Come impariamo noi? con quale logica, quali processi? e come impara l’Intelligenza Artificiale? ovvero gli algoritmi del machine learning che guidano scelte di marketing, intuizioni politiche, ecc.

tempo di lettura 10′

Sarà forse perché, da piccolo, ci ho giocato insieme. Ma ho sempre nutrito una certa simpatia per i pulcini. E così mi è rimasto in mente il racconto di qualche anno fa della storia centenaria (e del successo internazionale) della giapponese Zen-Nippon Chick Sexing School (since 1920s, chapeau!).

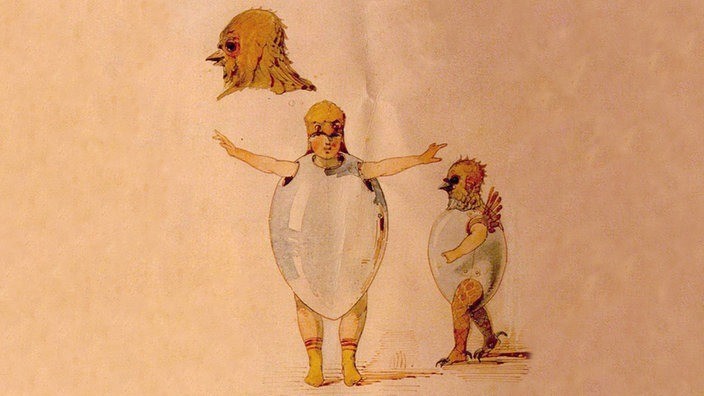

Non fatevi strane idee. Non si tratta dell’ennesima pratica esotica per broccolare le pollastrelle. Qui semmai le voci sex e chick sono intese nella loro accezione primaria, non in senso traslato. E il contesto, più sobriamente, è quello della produzione su larga scala di uova di gallina, in pieni roaring Twenties. Dovete sapere che in tali allevamenti, in tempi di taylorismo rampante, la brutale logica dell’efficacia esigeva che, tra i pulcini appena emersi dal guscio schiuso, soltanto le femmine, in quanto future produttrici di uova, avessero diritto alla sopravvivenza. Mentre i maschi, per evidenti ragioni, sin dai primi cip cip venivano considerati nient’altro che bocche (anzi becchi) da sfamare, e in quanto tali sterminati non appena possibile. Ma he voleva dire “appena possibile”? Si dà il caso che i pulcini non presentino alcuna riconoscibile caratteristica distintiva del proprio sesso prima della quinta settimana di vita. Così, onde risparmiarsi il costo di quel mese e poco più di nutrimento a sbafo, si era scatenata la corsa al chick sexing, la ricerca dei sistemi più precoci ed economici per individuare il sesso dei pulcini appena nati. Il metodo dei giapponesi – che fece letteralmente scuola in tutto il mondo – consisteva nel capovolgere il malcapitato pennuto, e sottoporlo a un’attenta osservazione del lato B (di cui ometto i particolari). Un’analisi che può non dire nulla ai comuni mortali, ma consentiva agli esperti, nel giro di pochi secondi, di individuare il sesso dei pulcini con elevatissimi livelli di accuratezza. Piccolo particolare: nessuno, neanche i chick sexer più esperti, era in grado di spiegare come fossero giunti alle loro conclusioni. Era chiaro che in qualche modo dovessero giocare un loro ruolo diversi indizi visivi; ma quale fosse la regola, o le regole, che li collegava alla diagnosi finale, nessuno era in grado di dirlo. E, men che meno, di trasmetterla in modo esplicito agli aspiranti pulcinologi.

Cosa diavolo facevano allora, nella Zen-Nippon (il percorso formativo durava un paio di anni), per tirare su le nuove leve di esperti?

In breve, procedevano per Trial & Error.

Immaginate la scena. Lo studente prende il suo primo pulcino, lo capovolge, lo scruta attentamente, e tenta di attribuirgli un sesso (diciamo, “maschio”). In realtà sarebbe più corretto dire “tira a indovinare”: il suo primo tentativo non può infatti pretendere di avere più chance del lancio di una moneta. Alle sue spalle il tutto viene osservato da un esperto che, non avendo, per quanto detto, gran che da insegnare, si limita a restituire un feed-back sulla risposta del neofita (ad esempio, previsione “esatta”); una certificazione che però costituisce un elemento centrale del processo. Secondo pulcino, secondo azzardo, con atterraggio diciamo sul pianeta delle femmine (e magari questa volta il verdetto dell’esperto è invece negativo). E così via. Nel corso di settimane di questa sorta di training, il cervello dello studente attraversa un percorso di plasmatura che lo porta, poco alla volta, a migliorare il proprio score di previsione, fino a raggiungere livelli eccellenti di performance. Anche se continuerà a non essere in grado di esplicitare il modello decisionale, l’avrà comunque interiorizzato.

Questa caratteristica costruzione di una conoscenza implicita, formata da processi che passano al di sotto del livello della nostra coscienza, appare come una di quelle componenti del System I (il nostro sottosistema mentale automatico) che non hanno un’origine innata, ma vengono costruite a partire dall’esperienza. Ma essa presenta anche un secondo motivo di interesse. Possiamo infatti osservare che questo modello di addestramento per tentativi, errori e feed-back presenta somiglianze con le modalità di apprendimento di quei computer che, inseriti anch’essi in un ciclo di trial & error, osservano e imparano dai dati esperienziali (non a caso chiamiamo questo campo machine learning, una delle aree a più rapido sviluppo dell’Intelligenza Artificiale). Anche essi ricevono in pasto tonnellate di esempi (i pulcini), associati ai relativi feed-back sul fatto che le loro previsioni tentative abbiano colto nel segno o meno (il giudizio dell’esperto). L’algoritmo su cui si basano imparerà progressivamente, e solo implicitamente, in che modo l’input è correlato all’output, e una volta addestrato potrà essere impiegato per formulare nuove previsioni (notate che anche uno strumento come questo, basato su correlazioni, e che quindi NON conosce la struttura causale del problema può funzionare perfettamente come mezzo di previsione, almeno nei limiti delle condizioni in cui è stato addestrato. Questa opacità degli algoritmi di machine learning è anche uno dei principali limiti della metodologia, e oggetto di dibattito).

È in questa chiave di lettura che ho ritrovato la nostra storia in un libro appena pubblicato:Mindmasters: The Data-Driven Science of Predicting and Changing Human Behavior, di Sandra Matz (Harvard Business Press).

L’autrice si interessa, come suggerisce il titolo, di come e quanto i computer siano in grado di interpretare dati per prevedere il comportamento umano (al fine di modificarlo). Non parliamo di dati qualsiasi, ma di quelle tracce digitali (digital footprints) che, ogni qual volta utilizziamo la tecnologia, lasciamo distrattamente (e talora intenzionalmente) in giro per il mondo. Alla portata, più o meno agevole, di alcuni miliardi di “vicini digitali”; che possono farne uso per il male, o – qui il libro prende una piega meno comune – per il bene. Di cosa parliamo? Solo per citare qualche esempio, lasciamo impronte facilmente accessibili come i post che pubblichiamo su Facebook, o i like con cui esprimiamo consenso o supporto a pagine e opinioni; o le news che abbiamo letto o condiviso su X/Twitter. Ma ve ne sono altre di più difficile facile raggiungibilità, come gli acquisti tramite carta di credito o smartphone; le interrogazioni su Google; il tracciato dei nostri spostamenti catturati dai i sensori GPS del cellulare; per non parlare di tutte le espressioni facciali, le azioni, gli incontri immortalati dall’onnipresente rete di telecamere pubbliche.

Di cosa dovremmo preoccuparci? Possiamo essere danneggiati dal fatto che i nostri vicini digitali possano accedere a qualche informazione isolata sul nostro conto? (la risposta che tendiamo a darci è in genere piuttosto auto-indulgente, visto che molti di questi dati, in cambio di servizi gratuiti, li abbiamo pubblicati intenzionalmente, come espressioni di un’identità – vera o cosmetizzata che sia – che desideriamo far conoscere agli altri). Se i nostri vicini “reali” possono vedere come vesto fuori casa senza poter accedere per questo al segreto della nostra mente, come possono quelli “virtuali” ricostruire il complesso puzzle della nostra psicologia da quattro tessere, magari neanche collegate tra loro?

Ma le cose non sono così semplici. Per cominciare, non sempre siamo consapevoli di quante tracce, e di che tipo, lasciamo in giro. Accanto ai dati che scegliamo esplicitamente di condividere con gli altri, ogni nostra interazione con la tecnologia digitale dissemina sempre, e in genere non intenzionalmente, dei residui comportamentali apparentemente innocui (ricerche su Google, dati sulle nostre carte di credito, geolocalizzazioni, ecc.). Se è vero che si tratta di dati cui la grande maggioranza dei nostri vicini digitali ha difficoltà ad attingere, sappiate che per quei pochi che possono accedervi illimitatamente, l’asimmetria informativa è enorme, e il vantaggio di disporne immenso. Questi operatori hanno in genere la possibilità di integrare dati da fonti e di tipo diversi, riempiendo con maggiore facilità il vuoto delle tessere mancanti del puzzle.

Ma sono i computer, insieme all’enorme scala dei dati con cui vengono nutriti, a fare la vera differenza. Nelle parole dell’autrice, “i computer possono tradurre informazioni apparentemente banali e innocue su ciò che facciamo in intuizioni molto intime su chi siamo, e, in ultima analisi, in prescrizioni su cosa dovremmo fare”. Il processo di psychological targeting si riferisce proprio all’uso dei computer per predire le caratteristiche psicologiche delle persone, e influenzarne, su tale base, pensieri, preferenze e comportamenti. Un decennio di ricerca nel campo (in parte condotta dalla stessa Matz) sembra confermare che machine learning e IA mettono chi dispone di dati sufficienti in grado di conoscerci piuttosto da vicino (più di un coniuge, si sostiene, purché il campione di dati utilizzato sia sufficientemente ampio)-

Non dovrebbe stupirci il fatto che le nostre tracce digitali parlino di noi. Altrimenti non saremmo i primi a consultarli quando dobbiamo assumere qualcuno, o uscirci a cena per un appuntamento galante. Quello che stupisce è quanto accurati nelle loro previsioni possano essere dei computer pur senza ricorrere ad alcuna teoria psicologica a supporto. E quanto possano conoscere di noi anche senza integrare le fonti di informazione, indagando sorgenti di dati voluminose ma isolate. Ecco qualche esempio.

- Status update di Facebook (quelle parole che modifichiamo sul nostro profilo per comunicare a tutto il mondo – o alle sole nostre amicizie – il nostro mood del momento). Solo guardando a queste parole, un algoritmo è in grado di identificare il genere dei loro autori con un’accuratezza del 90%.

- Se dagli aggiornamenti di status ci allarghiamo un po’, includendo i like che attribuiamo a pagine o post, i computer possono predire un intero range di caratteristiche sociodemografiche dei loro autori: oltre al genere, anche orientamento sessuale, età, uso eventuale di droghe, posizione politica, quoziente di intelligenza, soddisfazione di vita, e lo score sui cinque tratti di personalità del Big Five.

- Dall’analisi dei post sui social i computer arrivano facilmente ad individuare approssimativamente i nostri guadagni annui (con un margine di errore non siperiore ai 10.000$, un risultato sorprendente).

- Anche quando non stiamo intenzionalmente comunicando su noi stessi, il microfono e la fotocamera del nostro telefonino hanno molto da dire agli algoritmi interessati alla nostra psicologia. La loro analisi consente facilmente di valutare quando siamo tristi, eccitati, ansiosi o socievoli.

- Le ricerche su Google – come dimostra un altro libro fuori dal comune, Don’t Trust Your Gut di Seth Stephens-Davidowitz – sono un patrimonio di difficile ottenimento, ma permettono di ricostruire interi squarci di vita, e non è difficile costruire algoritmi che traducano automaticamente le richieste al motore di ricerca in profili psicologici.

- Sembra incredibile, ma, tracciando le posizioni tramite il GPS dello smartphone, i soliti algoritmi sono in grado di dirvi se siete predisposti a soffrire di schizofrenia, o di sviluppare una depressione!

Quest’ultimo punto esemplifica, peraltro, l’idea che sta dietro il libro della Matz. Nel 2017, Facebook è stata accusata di usare i propri dati per prevedere l’insorgere di una depressione tra i teenager americani, per poi vendere questa informazione ai loro inserzionisti. È facile vedere in una simile notizia un’esemplificazione degli allarmi che lo psychological targeting dovrebbe suscitare: il lato oscuro della notizia, tanto per l’uso di dati sensibili, quanto per la fragilità del target.

Ma, suggerisce, Matz, provate a rovesciare il focus.

Ad esempio (la ricerca della stessa autrice è stata utilizzata per questa e altre finalità simili), immaginate di impiegare lo stesso algoritmo per aiutare il potenziale target a diagnosticare una depressione prima che si sviluppi troppo (uno dei problemi della depressione è che in molti casi non viene diagnosticata, o lo è solo quando è tardi per risalire agevolmente la china). Magari collegando l’indagine a programmi di prevenzione, o alla segnalazione di strutture sul territorio. Test analoghi sono stati condotti su altre problematiche sociali notoriamente resistenti, come la dispersione scolastica, la consulenza alle famiglie a basso reddito quando prendono decisioni finanziarie, ecc.

Gli algoritmi che interpretano le ricerche su Google, a loro volta, sarebbero un ottimo complemento alle tecniche tradizionali per tracciare un quadro più realistico della situazione di trend delicati e sensibili (uso di droghe, problematiche di gender, ecc.) su cui le persone possono essere disincentivate a dichiararsi in un’intervista o un questionario).

Ho visto qualcosa di analogo (una specie di ju-jitsu che fa leva sulla forza dell’avversario per volgerla a proprio vantaggio) nell’ambito della behavior economics. I nudge sono piccole modifiche del contesto in cui viene presa una decisione, che, senza stravolgere l’aspetto costi/benefici della scelta, e senza limitare la libertà delle persone, la indirizza in modo impercettibile verso l’opzione che dalla prospettiva del decisore stesso appare più auspicabile. Per usare un esempio dei due “padri” dell’idea, Richard Thaler e Cass Sunstein, se voglio migliorare la dieta degli studenti in una mensa scolastica, posso eliminare i dessert (limitando così la libertà di scelta). Oppure spostarli su uno scaffale più scomodo da raggiungere, e mettendo della verdura a portata di mano (nudge).

Molte delle soluzioni che ricorrono ai nudge sfruttano quelle stesse lacune, o irrazionalità (tra cui i cosiddetti bias cognitivi), o difetti (nel nostro caso, un po’ di pigrizia) che normalmente ci inducono a prendere decisioni sbagliate. Nel caso dei nudge, governi, amministrazioni locali, aziende di tutto il mondo hanno trovato un modo a basso costo, efficace, e generalmente non conflittuale per volgere i nostri punti deboli a vantaggi per noi. Nel caso del machine learning, perseguire vantaggi per la comunità può entrare in rotta di collisione con quelle organizzazioni che oggi detengono, in regime quasi oligopolistico, la grande maggioranza dei dati.

Riusciremo per una volta a riprogettare il grande gioco di chi usa i nostri dati personali a nostro sfavore, e azionare le leve che dobbiamo manovrare per amplificarne gli effetti positivi?